안녕하세요, 에디터 SA입니다. 엔비디아의 GTC를 앞두고, AI와 AI 인프라에 대한 관심이 그 어느 때보다 뜨겁습니다.🔥 평소 AI 산업에서는 LLM, LMM 모델 출시와 같이 실질적으로 우리가 경험해 볼 수 있는 AI에 좀 더 관심이 집중되는데요. AI 인프라, GPU 등 각종 HW 요소가 더 주목받는 때가 바로 NVIDIA의 키노트 공개가 예정되어 있는 GTC 시즌입니다.😊

GTC에 대한 이야기는 GTC가 본격적으로 진행되고 젠슨 황의 키노트가 공개된 다음 해보기로 하고, 오늘 AI 피드에서 준비한 주제를 소개해볼까 해요. 이번 AI 뉴스룸 주제는 ‘인프라’입니다. AI 인프라 전문기업에 속한 에디터로서, AI 산업 동향으로 꼭 소개해 드리고 싶은 주제였는데요.😎 AI 인프라 분야에도 물량 확보 이슈부터, 엔비디아에 이어 2인자 자리를 놓고 치열하게 경쟁하는 다양한 기업들의 동향까지 다양한 소식들이 있답니다. 엔비디아 중심의 이야기만 접하고 계셨다면, 그 근처 혹은 또 다른 플레이어들의 이야기들을 살펴 보실 수 있는 기회가 되실 거예요.😉

그럼, 무시무시한 저력을 드러내고 있는 AI 인프라 스타트업의 이야기부터, 인프라로 고생 중인 다른 스타트업의 하소연까지, AI 피드에서 한 번에 확인해 보세요!

[ AI 인프라가 인재 영입에도 영향을 주다니요 ]

AI 인재 영입은 전 세계의 화두입니다. 스타트업부터 대기업, 글로벌 규모 테크 기업에 이르기까지 AI 분야 전문 인력을 확보하고자 큰 노력을 기울이고 있지요. 그런데, 이 인력 확보에 AI 인프라도 영향을 준다고 합니다. GPU가 채용에 영향을 준다니, 그게 무슨 소리인가 싶으시겠지요?🤔

인재들은 자신들의 전문성을 맘껏 펼칠 수 있는 환경을 원합니다. AI 분야도 예외는 아니겠지요. AI 개발 전문가들에게는 실험 스택과 부트스트랩 할 기존 모델이 갖춰져 있고, 리소스 확보에 대한 고민을 적게 할 수 있는 곳에서 일하고 싶은 것이 아주 당연한 일일 것입니다. 문제가 있다면 이런 환경은 그만큼의 정보력과 자본력을 갖춘 글로벌 테크 기업들이 갖출 수 있다는 것이지요.🤔

실제로 AI 검색으로 주목받고 있는 유망 스타트업 ‘퍼블렉시티’는, 메타의 수석 연구원으로부터 “H100 1만 개를 구한 후”에 다시 영입 제안을 해달라는 이야기를 들었다고 합니다.😲 엔비디아에서 굉장한 신제품을 키노트 때마다 공개하고 또 매년 출시하고 있지만, 여전히 A100, H100조차 물량 확보가 어렵다는 사실을 아시는 분들은 다 알고 계실 텐데요... 사실상 거절의 메시지인 셈이지요.

AI 개발 전문가들은 인프라의 중요성을 이미 알고 있을 수밖에 없습니다. 대량의 GPU를 확보한 인프라가 갖춰져 있지 않은 곳에서는, 그리 많지 않은 (그리고 어렵사리 구한🫠) GPU 몇 장을 다른 개발자들과 하나씩 나눠 쓰면서, 더뎌지는 모델 학습 속도를 중간중간 확인한 뒤 답답해하는 일이 잦을 텐데요. 그런 고민이 덜한 곳으로 가고 싶은 것은 ‘전문 인력’으로서 당연한 욕구가 아닐까 싶습니다.

퍼블렉시티 CEO인 아르빈드 스리니바스에게 AI Pub으로 한정된 인프라 자원을 효율적으로 나눠 쓰는 방법이 있다는 걸 알려드리고 싶네요.🤔 메타처럼 H100을 30만 개 넘게 보유하는 것은 불가능하겠지만, 보유하고 있는 GPU가 단 30장이더라도 메타, 구글 부럽지 않게 인프라를 효율적으로 쓸 방법이 있다는 걸 안다면, 아쉽게 놓친 인재들을 붙잡을 수 있지 않을까요?

[ 세계에서 가장 빠른 AI 프로세서, 미국 스타트업에서 만들었다! ]

엔비디아 H100을 62개 합했을 때의 성능을 구현한 AI 프로세서가 세상에 공개되었습니다.😲 크기는 12인치 웨이퍼 정도인 이 AI 프로세서의 이름은 ‘WSE-3(Wafer Scale Engine 3)’. 세계에서 가장 빠른 AI 프로세서인 셈인데요. 이 프로세서를 내놓은 곳은 우리가 흔히 알고 있는 글로벌 테크 기업이 아닙니다. 미국에 있는 AI 칩 스타트업 ‘세레브라스’라는 곳입니다.

세계에서 가장 빠르다는 프로세서 ‘WSE-3’은 TSMC 5나노 공정으로 제작된 웨이퍼 한 개 크기의 거대한 프로세서인데, 4조 개의 트랜지스터가 포함되어 있습니다. 무려 90만 개의 AI 코어와 44GB의 온 칩 SRAM을 하나로 통합, 이론상 엔비디아 H100 GPU 62개에 해당하는 최대 125 FP16 페타플롭스(PF) 성능을 제공하는데요. 연산 횟수로 환산하면 1초에 125,000조 번 연산할 수 있는 성능입니다. 정말, 엄청난데요!😲

WSE-3은 세레브라스의 슈퍼컴퓨터 'CS-3'를 구동합니다. 이 컴퓨터는 최대 24조 개의 매개변수로 AI 모델을 훈련하는 데 사용할 수 있는데요. 1.5TB, 12TB 또는 1.2PB의 외장 메모리를 지원할 수 있다고 합니다. 그 정도의 외장 메모리라면, 파티션이나 리팩토링 없이 그냥 대규모 모델을 저장할 수 있을 겁니다.🤓 개발 과정에서 어려움을 좀 덜고, 효율성도 챙길 수 있겠지요.

그뿐만 아니라 CS-3는 최대 2,048개의 시스템으로 클러스터를 구성할 수 있습니다. 만약 4대의 시스템으로 클러스터를 구성할 경우, 700억 매개변수의 '라마 2'를 단 하루 만에 훈련할 수 있다고 하네요.😵💫 엔비디아 DGX-H100에 비하면 성능은 8배가 빠른 것이고, 메모리는 1,900배가 더 많으며, 처리할 수 있는 모델의 크기도 600배 정도 차이가 납니다.

이야기만 들으면 WSE-3보다 CS-3이 더 대단해 보입니다. 물론 실 활용 관점에서 보았을 때 AI 개발을 위한 완벽한 생태계가 구축된 엔비디아의 장점을 무시할 수 없겠지만, 작은 스타트업에서 이 정도로 엄청난 AI 프로세서를 개발하다니, AI 인프라 산업의 변화 속도와 폭도 무시무시하게 빠른 것 같네요.

[ 텐스토렌트의 신제품이 AI 추론 전용이라고? ]

테슬라의 오리지널 자율주행 칩으로 유명한 텐스토렌트 CEO 짐 켈러가 GPU의 대안이 될 하드웨어 모듈을 내놓았습니다. RISC-V 기반 그레이스컬 프로세서를 탑재한 추론 전용 모듈, PCIe젠 4카드인데요. ‘그레이스컬 e75’와 ‘그레이스컬 e150’ 이렇게 두 가지가 출시되었습니다. e75 모델은 75W에서 작동하는 단일 그레이스컬 프로세서를 갖춘 로우 프로파일이며, 절반 길이의 PCIe 젠 4카드입니다. e150 모델은 75 모델보다 고급 모델인데요. 최대 200W에서 작동하고, 전력과 처리량의 균형을 유지하는 그레이스컬 프로세서를 포함하고 있습니다. 높이는 3/4 정도 됩니다.

PCIe는 PCIe(Peripheral Component Interconnect Express)는 캡처 카드나 무선 카드와 같은 주변 장치 뿐 아니라 그래픽 카드와 SSD를 연결하는데 일반적으로 사용되는 고대역폭 확장 버스입니다. PC를 조립해보신 적이 있다면, 마더보드에서 수평으로 되어 있는 PCIe 슬롯이 있습니다. 즉, 우리가 평소에 사용하는 데스크탑 안에도 존재하는 거예요. 11세대 인텔 코어 CPU라면 PCIe를 4세대까지 호환 사용할 수 있답니다.

우리가 모르고 있었을 뿐, 일상에서 쓰이고 있던 하드웨어 모듈입니다.🤓 그런데 이게 ‘AI 추론 전용’으로 따로 출시된 거예요. 짐 켈러가 내 놓은 그레이스컬 모듈 2가지에 탑재된 그레이스스컬 프로세서는 12나노 공정의 2세대 AI 프로세서인데요. 텐식스로 알려진 120개 코어 그리드와 120메가바이트(MB) S램을 통합했습니다. 네트워크 통신 하드웨어와 함께 제공되므로 DRAM 대신 네트워크를 통해 직접 통신할 수 있고요. 전력효율은 65와트, 92테라플롭스 성능을 갖추고 있다고 합니다.

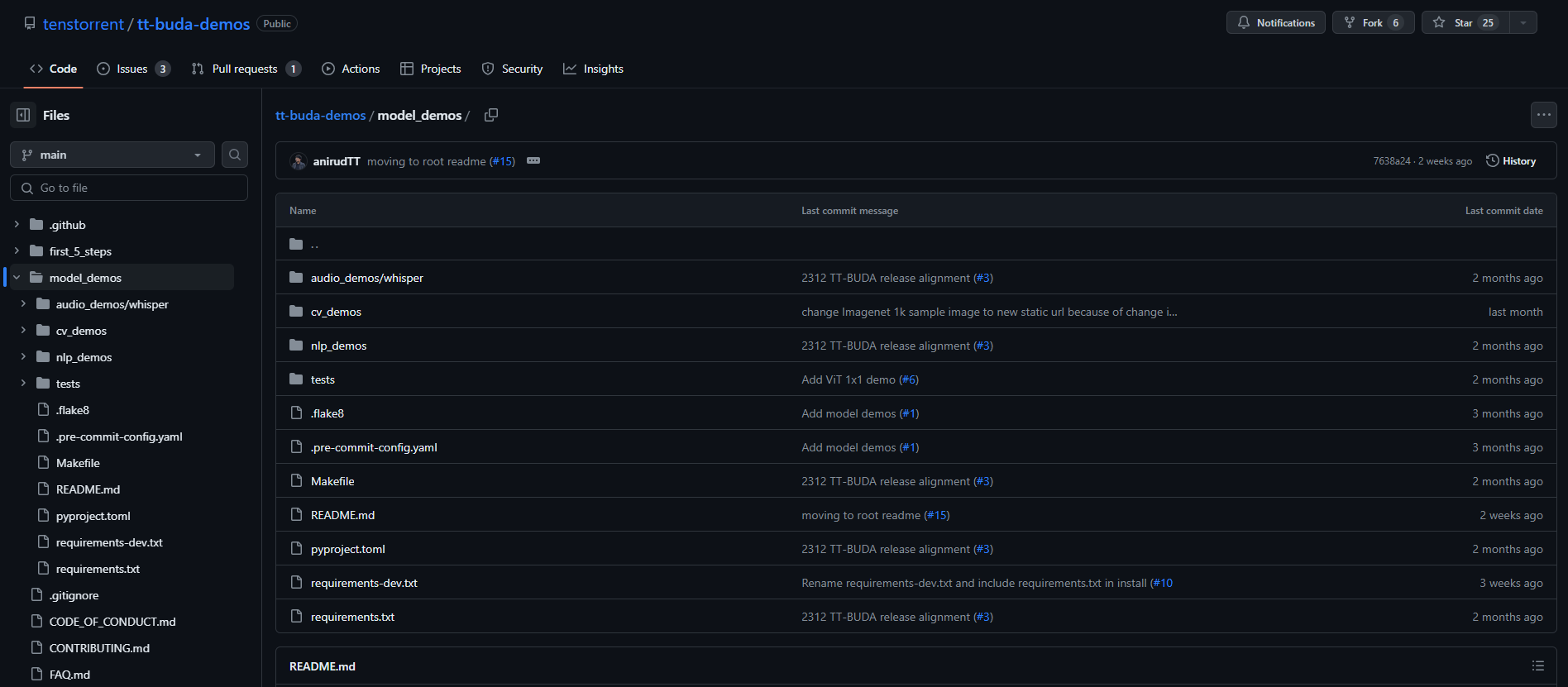

하드웨어 모듈만 발표한 것이 아닙니다. 그레이스컬 기반 소프트웨어 개발 키트(DevKits)도 공개했습니다. 지난주 AI 피드에서 엔비디아의 성공 요인에 하드웨어와 함께 매력적인 솔루션, 키트, 커뮤니티로 생태계를 형성했던 점을 이야기했었는데요.🙂 그레이스컬도 비슷하게 생태계를 구축해서, 엔비디아 GPU가 아닌 다른 대안도 제시해 보려 하는 것 같습니다. 🤔 함께 내놓은 개발 키트에는 모델을 바로 실행하려는 경우에 맞춘 'TT-부다(TT-Buda)'가 있고요. 기존 모델을 사용자 정의하거나 새로운 모델을 작성하는 경우를 위한 'TT-메탈리움(TT-Metalium)'도 있습니다.

그레이스컬 개발 키트는 자연어 처리 작업을 위한 버트(BERT), 이미지 인식을 위한 레스넷(ResNet), 음성 인식 및 번역을 위한 위스퍼(Whisper), 실시간 객체 감지를 위한 욜로v5(YOLOv5), 이미지 분할을 위한 U-넷(U-Net)을 포함한 다양한 모델을 지원한다고 합니다. 그레이스컬 모듈의 시작은 일본의 첨단 반도체 기술 센터(LSTC)에서 최첨단 2나노 AI 가속 칩을 구축하는 데 대한 파트너십이었다고 하는데요. 세상에 공개된 후의 파장은 파트너십 그 이상이지 않을까 싶습니다.🤔 텐스토렌트는 올해 1월 한국 시장에도 발을 들였으니, 앞으로의 행보를 지켜보아도 좋겠네요.🙂

그러고 보니, 요새 AI 칩들이 ‘학습’보다는 ‘추론’에 초점을 맞추고 있는 것 같습니다. 실제로 엔비디아 데이터센터 사업 중 40% 이상이 AI 학습이 아니라 AI 추론 작업에 초점을 둔 시스템 배치에 관련된 것이었다고 해요. AI 추론은 학습에 비하면, GPU 성능이 강력할 필요가 없는데요. (물론 상대적인 관점이지만요.) AI 추론 모델은 학습 AI 모델에 ‘명령’만 하기 때문입니다. 절대 다수의 데이터를 무한히 학습하는 AI 모델에 비하면, 학습 AI에게 “이 정보를 처리하고 대답해” 정도의 전달만 하면 되는 모델은 당연히 인프라 성능에 구애 받는 정도가 적겠지요?

물론, 추론용 칩에서도 효율적으로 인프라를 사용하는 것은 여전히 중요한 문제가 됩니다. AI 추론용 칩의 성능과 가격은 ‘상대적으로’ 고성능 GPU나 하드웨어에 비해 저렴한 것이니까요. 여전히 AI 인프라는 구축부터 운영 유지까지 많은 자본이 필요하고요.🤑 정확한 데이터를 토대로 인프라를 구축하는 RA:X의 합리성과, 그 인프라를 야무지게 나누어 쓰고, 또 우선순위에 맞춰 할당을 계획하는 AI Pub의 효율성이 필요한 시점인 것 같네요. 지금까지 에디터 SA였습니다.

'Tech & Product > AI 뉴스룸' 카테고리의 다른 글

| 엔비디아만 있는 게 아니다! AI 인프라, AI 칩의 오늘은? (0) | 2024.04.11 |

|---|---|

| 화제의 GTC 2024, 신제품과 새로운 포부가 드러난 엔비디아의 키노트 내용은? (3) | 2024.03.22 |

| 영상 업계를 뒤흔들 화제의 영상 AI '소라', 한 번 지켜 보라! (0) | 2024.02.28 |

| MS가 선정한 2024년의 AI 트렌드는? TEN이 추가 선정한 AI 트렌드까지! (2) | 2024.02.15 |

| 이러다 생성 AI가 사람도 생성하겠어요! (2) | 2024.02.02 |